Artículos Científicos

GOBIERNO ELECTRÓNICO Y ACCESIBILIDAD: DISPONIBILIDAD DE SERVICIO EN PLATAFORMAS ONLINE ESTATALES DE LA ARGENTINA[1]

ELECTRONIC GOVERNANCE AND ACCESSIBILITY: SERVICE AVAILABILITY IN PUBLIC ONLINE PLATFORMS OF ARGENTINA

GOBIERNO ELECTRÓNICO Y ACCESIBILIDAD: DISPONIBILIDAD DE SERVICIO EN PLATAFORMAS ONLINE ESTATALES DE LA ARGENTINA[1]

Ciencias Administrativas, núm. 15, 2020

Universidad Nacional de La Plata

Recepción: 21 Agosto 2018

Aprobación: 23 Septiembre 2018

Resumen: Este artículo presenta los resultados de un relevamiento anual de calidad de servicio de servidores estatales de la Argentina. Por medio de ello, se busca dar cuenta de la importancia de la evaluación sistemática de la infraestructura pública digital de servicios de gestión e información gubernamental. En el caso de la infraestructura estatal, la importancia de su estabilidad técnica tiene una relevancia especial, en tanto la oferta de servicios estatales representa en muchos casos el acceso o la denegación de derechos tan básicos como la educación, la salud o el trabajo. El monitoreo se realizó durante 12 meses sobre 59 sitios dependientes del estado nacional, pudiendo observarse en ellos un rendimiento deficiente en comparación a los grupos de servicios seleccionados como grupos de referencia. Este peor rendimiento se registró tanto en su nivel de disponibilidad como en el tiempo total de respuesta a las solicitudes. Los sitios dependientes del Estado nacional mostraron a su vez patrones de falla diferenciados según grupo de pertenencia (ministerios nacionales, organismos estatales y Universidades nacionales) sugiriendo la existencia de infraestructuras y formas de trabajo heterogéneas que confluyen en todos los casos en altos niveles de no disponibilidad de las plataformas ofrecidas.

Palabras clave: Argentina, disponibilidad, gobierno electrónico.

Abstract: This article shows the results of an annual survey on the service quality of state-owned servers in Argentina. By means of this survey, it seeks to account for the importance of the systematic evaluation of the public digital infrastructure for government information and management services. In the case of the state infrastructure, the importance of its technical stability is especially relevant, since the state services offering represents, in many cases, the access or denial of very basic rights such as education, health or work. The monitoring was carried out over 12 months on 59 sites dependent on the National Government. A deficient performance was observed in comparison with the groups of services selected as reference groups. This poor performance was registered both in terms of availability and the average request response time. The sites depending on the National Government showed differentiated failure patterns according to the group to which they belonged (national departments, state agencies and national universities), suggesting the existence of heterogeneous infrastructures and work methods that converge in all cases in high levels of unavailability of the offered platforms.

Keywords: Argentina, quality of service (qos), e-government.

Introducción

La reciente revolución informacional que trajo aparejada internet y su facilidad para conectar a bajo costo grandes cantidades de computadoras y personas a la distancia puso a los estados nacionales bajo nuevos desafíos. La gestión de sus procesos administrativos a lo largo de los territorios, así como la difusión de sus productos estadísticos y científicos, pueden ahora estar accesibles a la ciudadanía de formas impensables antes de este nuevo recurso tecnológico.

La difusión de la informática primero, y de las redes de computadoras después, completaron un proceso donde la lenta y costosa distribución de información en papel cedió paso a la posibilidad de replicar de manera casi ilimitada grandes volúmenes de datos, eliminándose casi por completo las necesidades de transporte de esa información[2]. En la gestión pública, esto abrió el campo del ‘gobierno electrónico’, que compete no sólo a cómo los Estados distribuyen información de interés general sino a cómo ofrece por medio de estas nuevas tecnologías vías de recepción de solicitudes y de participación ciudadana (Kaufman, 2006).

Sin embargo, tanto en la Argentina como en otros países, estas posibilidades inéditas no se han dado sino a la par de nuevos problemas y limitantes, y de complejidades institucionales propias de cada país. Las dependencias estatales que durante décadas trabajaron para resolver sus gestiones puertas adentro, a partir de expedientes concebidos y organizados como carpetas en papel, deben ahora responder a un vertiginoso ciclo de conversión, digitalización y exposición pública. La informatización en la Ciudad de Buenos Aires del sistema de inscripciones escolares es uno de los tantos casos que mundialmente han dado muestras de los enormes riesgos que una estrategia desacertada de puesta online de un servicio estatal puede traer aparejada[3].

En este contexto, cabe preguntarse, al menos tentativamente, cuáles son las capacidades de un estado en un momento histórico dado para responder a un proceso de innovación tecnológica que ni nace en su seno[4] ni responde a sus fines operativos primarios[5]. En la Argentina, siguiendo la tendencia observada en los países centrales en la década precedente (Choudrie, Ghinea y Weerakkody, 2004, p. 2), la adopción por parte del Estado de internet como medio de provisión de servicios y de difusión de información de interés público ha ido generalizándose, y la gestión de turnos por vías electrónicas atravesaba para el año 2016 un sinnúmero de puntos de contacto entre la población y el estado. La consulta de padrones electorales, la solicitud de vacantes para escuelas, el reclamo de problemas urbanos de arbolado o seguridad pública son algunas de las muchas gestiones que se han visto reorganizadas para aprovechar las ventajas tecnológicas de disponibilidad y costo que su informatización supone.

Adicionalmente a esto, dos leyes de gran importancia a mediano plazo han sido sancionadas en el país en el último lustro: la ley de acceso abierto y la ley de acceso a la información pública[6], en línea con otras iniciativas regionales de gobierno abierto (Naser, Ramírez-Alujas y Rosales, 2017). La primera de ellas impone la obligación de publicación de los resultados de investigación y de las fuentes primarias de toda investigación científica financiada por el Estado Nacional (Russo y De Grande, 2015), mientras que la segunda garantiza el derecho al acceso a la información pública y establece como principio de gestión la transparencia activa de las acciones de gobierno, que marca la necesidad de visibilidad de los actos de gobierno incluso en ausencia de solicitud expresa.

Si bien estas dos iniciativas han puesto en la agenda académica y de organismos estatales la necesidad de aumentar la disponibilidad de la información social existente, no hemos encontrado a la fecha iniciativas estatales para medir o reportar la calidad de servicio de la infraestructura estatal de información. Esto es: ¿en qué medida la oferta estatal de servicios e información por vías electrónicas es efectivamente accesible y funcional?

La pregunta así formulada es por cierto muy amplia, y abarca cuestiones tan diversas como la evaluación de la ergonomía y usabilidad de las plataformas ofrecidas, la accesibilidad geográfica de internet y sus dispositivos a lo largo del territorio, la calidad de la infraestructura eléctrica y de conectividad, la calidad de la información, así como también cuestiones vinculadas a la ‘alfabetización digital’ de los diferentes sectores de la población (Levis, 2006; Olvera-Lobo y Aguilar-Soto, 2011, p. 36; Venkatraman y Alazab, 2014, p. 104). Las propuestas para organizar una evaluación de la calidad de los servicios online son tan diversas que, para el año 2007, Halaris y equipo daban cuenta de 7 propuestas específicas para el área de gobierno electrónico, y de 24 publicadas para servicios electrónicos en general (Halaris, Magoutas, Papadomichelaki y Mentzas, 2007, p. 380).

En dicho contexto, esta investigación se ha planteado una meta específica, que consistió en construir una herramienta para monitorear durante doce meses la disponibilidad del servicio de un conjunto de sitios estatales de servicios e información pública. Con ello se ha buscado avanzar en dos objetivos.

El primero de ellos fue hacer una primera mirada a vuelo de pájaro respecto de qué tanto la infraestructura estatal de sitios públicos en internet de la Argentina adolecía de problemas en términos de disponibilidad (servidores que responden) en comparación con una muestra de proveedores privados de servicios comerciales en el país. La ausencia de datos a este respecto parecía justificar su producción primaria[7].

El segundo objetivo fue evaluar qué tan complejo –en términos técnicos de creación y económico de costo de sostenimiento– podía resultar producir una herramienta de medición de disponibilidad de servicio para un grupo amplio de servidores, y en consecuencia, en qué medida podría el mismo Estado sostener una herramienta similar para publicar y alertar sobre la existencia de actores poco estables dentro de su oferta de servicios online.

En la siguiente sección comentaremos los aspectos metodológicos de la medición realizada. Luego, se detallan los resultados obtenidos, realizando un análisis descriptivo de ellos. Finalmente, se discuten en las conclusiones los rasgos más salientes de la información producida.

Metodología

La herramienta

Varios fueron los criterios que guiaron el diseño o elección de la herramienta de medición a utilizar. Estos pueden resumirse de la siguiente manera:

-

La herramienta debía ajustarse a estándares abiertos, es decir, que tanto el código fuente como los datos primarios que recolectara debían poder estar accesibles. Esto facilitaba su reusabilidad para futuras mediciones o replicas en otros países, así como también mejoraba la verificabilidad de los procedimientos aplicados.

-

No debía estar orientada a la detección y corrección en vivo de problemas (por ejemplo, enviando alertas cuando un sitio no respondiera) sino al registro sistemático del monitoreo. Esto por ejemplo imponía la necesidad de distinguir entre problemas de respuesta y problemas de conectividad, y a establecer esquemas redundantes de salvaguardo de los resultados.

-

No debía requerir de un ambiente de ejecución complejo (tal como un entorno Windows dedicado) para que fuera fácil distribuirla en espacios de ejecución remota. La ejecución debía buscar asegurar un ambiente que durante los 12 meses no sufriera ni apagones ni ‘reinicios’ de sistema operativo que la pusieran inactiva.

-

Debía minimizarse el uso de recursos, evitando almacenar datos en forma extensa. El exceso en el uso de espacio de almacenamiento o de tiempo de procesador podía chocar con restricciones que llevaran a interrumpir la continuidad de la medición. En este sentido, para evaluarse la disponibilidad a intervalos de 10 minutos, durante un año, estimábamos producir para 130 sitios casi 7 millones de registros (6 registros por hora x 24 horas x 365 días x 130 sitios = 6,83 millones de filas).

Considerando estos requerimientos, la estrategia de medición se apoyó en la codificación de un conjunto de scripts en lenguaje Python. Este lenguaje, además de ser ampliamente utilizado en proyectos académicos y de ejecutarse en forma homogénea en diferentes sistemas operativos, ofrecía funciones suficientes para el pedido de datos a otros sitios y para el procesamiento en paralelo de las colas de pedidos. Plataformas pagas de internet para el monitoreo de sitios suponían un costo mucho mayor (para nuestra fase exploratoria de 130 sitios), no siempre con el tipo de registro buscado como resultado.

Para el funcionamiento de la herramienta de monitoreo (de ahora en más la llamaremos ‘monitor’) se definieron las siguientes pautas de funcionamiento:

-

En primer lugar, la herramienta debía procesar la lista de sitios a visitar respetando el intervalo de tiempo esperado entre cada verificación de cada sitio. Como no hay un modo externo de saber si un sitio está respondiendo que no sea solicitarle una página, no debían requerirse páginas a intervalos tan cortos que saturaran los servidores investigados. En todos los casos se estableció que el intervalo entre consultas para un mismo servidor sería de 10 minutos, siendo una frecuencia que balanceaba la voluntad de construir un monitoreo ‘continuo’ con una demanda que fuera poco invasiva para los servidores a consultar.

-

Para evitar utilizar tiempo de procesamiento innecesario, la aplicación se ejecutaría nuevamente en cada intervalo de medición (no se mantendría en memoria entre mediciones), pudiendo funcionar como una tarea programada (Windows) o cron (Linux).

-

Debido a que ejecutar todos los pedidos a la vez (cada 10 minutos) podía generar cuellos de botella (en la red o la paralelización de los pedidos) que distorsionaran la medición de los tiempos de respuesta, el monitor debía repartir los pedidos de modo de ejecutarse a intervalos de 1 minuto, verificando allí un décimo del total de sitios a validar.

-

En estos subintervalos de 1 minuto, el monitor debía a su vez generar un número limitado de colas de ejecución (5 colas de ejecución) para ir asignando los pedidos en estas colas a medida que se completaban los anteriores, de modo de no saturar la conexión de red con pedidos y distorsionar los tiempos de respuesta.

-

En todo momento, el monitor debía controlar los tiempos de espera, ya que la medición de un subintervalo no podía encimarse con la del subintervalo siguiente. En caso de acabarse el tiempo sin respuesta y habiendo pedidos pendientes, se debía registrar la imposibilidad de ejecutarlos sin extenderse sobre el siguiente subintervalo.

-

El registro de los resultados debía realizarse en archivos binarios, produciendo un archivo por sitio monitoreado en cada mes. Cada registro se guardaría en bloques de 3 bytes, dando el primero el status de la respuesta (indicando si el pedido fue respondido exitosamente[8]) y los 2 bytes siguientes el tiempo insumido en milisegundos hasta completarse el envío de la respuesta. La posición del registro en el archivo representaría el momento en el tiempo, asignándose por cada posición de 3 bytes un desplazamiento en el intervalo de medición (10 minutos) con respecto al inicio del mes.El registro de los resultados debía realizarse en archivos binarios, produciendo un archivo por sitio monitoreado en cada mes. Cada registro se guardaría en bloques de 3 bytes, dando el primero el status de la respuesta (indicando si el pedido fue respondido exitosamente[8]) y los 2 bytes siguientes el tiempo insumido en milisegundos hasta completarse el envío de la respuesta. La posición del registro en el archivo representaría el momento en el tiempo, asignándose por cada posición de 3 bytes un desplazamiento en el intervalo de medición (10 minutos) con respecto al inicio del mes.

-

Al final de cada día, un proceso debía subir una copia de los archivos modificados a un servidor remoto para tener posibilidad de resguardar y analizar la información sin interferir en los datos productivos.

Con este esquema[9], se realizaron pruebas durante noviembre y diciembre de 2016, comenzándose la medición en enero de 2017.

La muestra

En la elección de sitios incluidos en el relevamiento, si bien se incluyeron principalmente sitios vinculados a la administración nacional, fueron incorporadas también algunas dependencias de la Ciudad Autónoma de Buenos Aires y de la Provincia de Buenos Aires. Se incluyeron sitios de uso masivo de alcance nacional, como diarios nacionales (periódicos) y prestadoras de servicios públicos, así como también sitios de servicios privados tales como cadenas de supermercados o venta online.

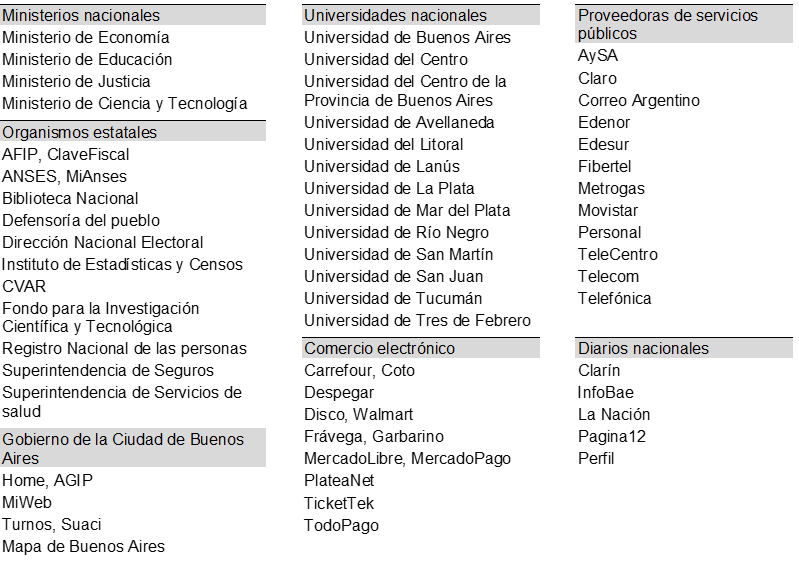

Resultados de estos criterios, en la Figura 1 puede verse la lista de sitios agrupados por sector de pertenencia. En el caso de las Universidades nacionales, se incluyó por cada una de ellas sus páginas de inicio, sus repositorios institucionales y el ingreso a sus sistemas de gestión académica si estuvieran disponibles.

Figura 1

Sitios incluidos en la muestra según sector. N=131 sitios, dependientes del estado nacional: 59 sitios.

Fuente: elaboración propia en base a relevamiento de disponibilidad

La medición

La medición se realizó desde las 0:00 horas del primero de enero de 2017 hasta las 23:59 del 31 de diciembre del mismo año. En este período, el monitor consultó cada uno de los sitios incluidos en la muestra a intervalos de 10 minutos, totalizando 5.516.828 verificaciones en las categorías de sitios analizados en este artículo[10], siendo 3.257.496 de ellos correspondientes a sitios dependientes del Estado nacional.

Cabe mencionar, con relación a las condiciones de medición, que la Argentina ha sufrido por décadas de problemas en el suministro de energía eléctrica que provocan anualmente cortes en la provisión de electricidad, especialmente en los períodos de mayor consumo[11].

Dada la importancia que tenía el preservar la medición de fallas atribuibles a la infraestructura de las instituciones académicas desde donde se realizara, así como de interrupciones en la provisión eléctrica, se decidió alojarla en un servicio provisto por terceros, fuera del territorio evaluado. Esto permitía que los pedidos ingresaran desde una ubicación externa, y se mantuvieran neutrales respecto al impacto de las dificultades locales que se pretendía evaluar.

En consecuencia, los ‘scripts’ de funcionamiento del monitor fueron subidos y ejecutados desde una instancia de tipo EC2 de Amazon Web Services (AWS), en el set de servidores en Estados Unidos, costa Oeste. Este proveedor de servicios de virtualización ofrecía gratuitamente la ejecución de aplicaciones dentro de los primeros 12 meses (máquinas virtuales de trabajo), por lo que el funcionamiento del monitor no tendría costo de funcionamiento para el proyecto.

Para considerar como variable a controlar la fiabilidad de la infraestructura de medición, se incluyó en el monitor el registro de eventos de no-conectividad al inicio de cada ciclo de medición. De este modo, para poder diferenciar la falta de servicio en las páginas evaluadas con la falta de conectividad del monitor, este evaluaba su conectividad antes de realizar los demás pedidos. Si este pedido fallaba, marcaba el registro de ese minuto como sin conectividad[12].

Resultados

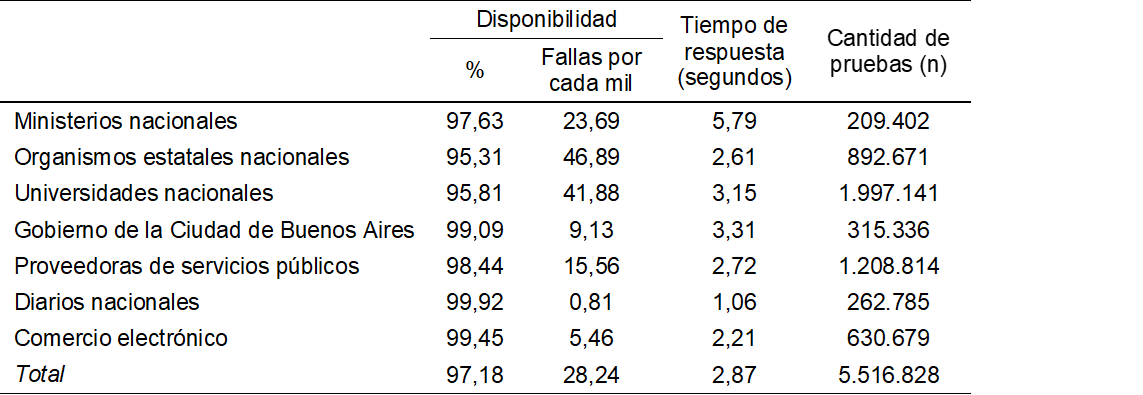

Estado nacional vs resto

En la Figura 2 pueden verse los resultados por categoría de los sitios evaluados para el total del año 2017. Un primer emergente a destacar es el bajo rendimiento de los sitios dependientes del Estado nacional, los cuales han sido agrupados en tres categorías: Ministerios nacionales, Organismos estatales nacionales y Universidades nacionales.

La primera categoría reúne sitios institucionales de una selección de ministerios nacionales, los cuales estarían radicados en la Ciudad de Buenos Aires (por ser la sede del gobierno federal). Estos servidores pueden o no compartir su infraestructura de datos, hecho que debería evidenciarse en los rendimientos similares o disímiles de sus contenidos.

La segunda categoría incluye sitios de organismos dependientes de la administración pública nacional, los cuales si bien dependen de ministerios nacionales, podrían tener un tipo de respuesta diferenciado debido a la mayor complejidad de los servicios que proveen. Mientras que los sitios institucionales de ministerios nacionales muestran contenidos usualmente ‘estáticos’, los sitios fichados como organismos nacionales ofrecen sistemas de reserva de turnos para la gestión de trámites personales o la gestión de trámites online, tanto de tipo tributario, de acceso a la seguridad social, así como la solicitud de subsidios entre otros.

La tercera categoría reúne a Universidades nacionales, las cuales a diferencia de los dos grupos de sitios anteriores agregan a su disponibilidad el desafío de la distribución geográfica. A pesar de la organización nacional de tales universidades (es decir, de ser dependientes del gobierno federal), su funcionamiento autónomo hace esperable que sus servidores de contenidos repliquen la distribución geográfica de estas sedes académicas, y que por lo tanto se encuentren repartidos por las diferentes regiones del país en que se encuentran.

De este modo, los tres grupos esperan representar realidades diferentes de la infraestructura estatal nacional, siendo los dos primeros grupos servidores dependientes de organismos centralizados, y el tercer grupo un conjunto de instituciones distribuidas en el territorio.

En este sentido, como primer resultado, emerge el hecho de que en los sitios dependientes del Estado nacional la cantidad de pedidos fallidos cada mil solicitudes duplica lo observado en las categorías no dependientes del Estado nacional.

Mientras que en las demás categorías los sitios no superan en promedio las 10 fallas por cada mil pedidos (con excepción de proveedoras de servicios públicos, las cuales dependen del control del Estado nacional), en las tres categorías de sitios dependientes del Estado nacional las fallas se encuentran por encima de los 23 pedidos por cada mil.

En el caso de los Organismos estatales (grupo en el que se encuentran plataformas proveedoras de servicios como la página de la ANSES o la AFIP) este valor asciende a 46,89 pedidos fallidos por cada mil recibidos. En la franja de sitios de ministerios nacionales, que ofrecen contenidos institucionales similares en funcionalidad al grupo de diarios nacionales (periódicos de noticias), la cantidad de fallas por cada mil asciende a 23,69, mientras que los diarios nacionales han fallado por debajo de un pedido por cada mil solicitudes.

Respecto del tiempo total de respuesta (la cantidad de tiempo insumido hasta la recepción de la página), el rendimiento de la franja estatal es también deficiente comparativamente, siendo el tiempo de las páginas de inicio de los ministerios nacionales el doble del tiempo promedio general, con valores de 5,79 y 2,87 segundos respectivamente.

Figura 2

Disponibilidad y tiempo de respuesta completa de los sitios por categoría. Período: enero-diciembre 2017.

Fuente: elaboración propia en base a relevamiento de disponibilidad

Análisis de causas

Entre las diversas causas que pueden restar disponibilidad a un servidor se encuentran tanto problemas en los procesos de trabajo como en la infraestructura o variaciones en la demanda.

Los procesos de trabajo poco consistentes pueden llevar a cambiar el software de las páginas, o sus datos, sin prever el impacto en la caída de disponibilidad durante estas acciones. Estas pueden incluir la actualización de sistemas operativos o hardware del servidor o la respuesta deficiente ante situaciones excepcionales que obstaculicen el funcionamiento de las aplicaciones (tal que el agotamiento del espacio de disco de un servidor o su rotura).

En las fallas de infraestructura puede ubicarse problemas en la provisión de electricidad y conectividad, tanto de servicios propios como de bases de datos o servicios externos que las aplicaciones puedan requerir.

Adicionalmente, los diferentes sitios pueden recibir picos de demanda que provoquen encolamiento de pedidos, saturación de accesos a las bases de datos o bloqueos entorno a recursos que la aplicación accede para resolver los pedidos efectuados.

Si bien estas situaciones sólo pueden analizarse en forma plena accediendo a los registros del servidor, evaluando las características de la infraestructura (su nivel de redundancia, su grado de saturación en horas normales de trabajo) y conociendo la cultura organizacional de sus equipos de trabajo, el monitoreo externo puede permitir distinguir algunos escenarios posibles de mal funcionamiento.

De esta forma, los cortes de luz en meses de mayor demanda no pueden ser la causa de falta de disponibilidad durante todo el año (sólo deberían manifestarse en los meses de temperaturas más extremas); los picos de uso difícilmente ocurran a altas horas de la madrugada, y la falta de disponibilidad por períodos largos en algunos servidores posiblemente dé cuenta de problemas de otra naturaleza que los de aquellos con períodos cortos de falta de disponibilidad.

Asimismo, aumentos atípicos en la duración de las respuestas pueden dar cuenta de recursos escasos en los servidores (al saturarse el servidor de pedidos los tiempos de respuesta se amplían), mientras que los errores de red (servidor no responde) son distinguibles de los errores de instalación de aplicaciones inválidas (se actualiza la aplicación con versiones poco probadas que fallan en forma generalizada) por sus códigos de error.

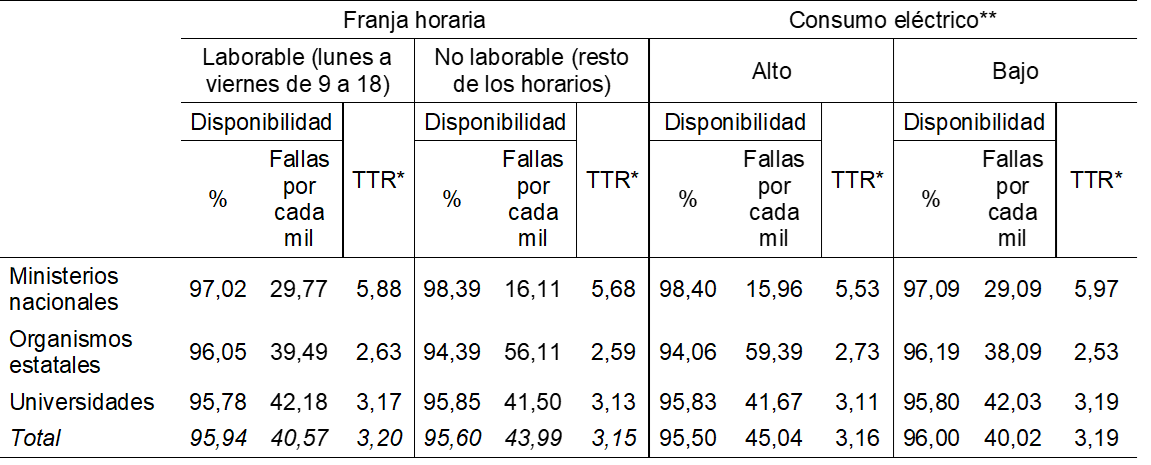

La apertura por franja horaria y por tipo de mes de consumo eléctrico es una primera aproximación para intentar caracterizar los problemas de infraestructura que pueden estar aumentando la falta de disponibilidad en sitios estatales en comparación al resto. En la Figura 3 puede verse el efecto diferencial de la franja horaria y de la época del año según grupo de sitios.

Con respecto a la franja horaria, en la figura puede verse un comportamiento singular en cada uno de los tres grupos. Los ministerios nacionales, con sitios de contenido mayormente estático, aumentan sus fallas en horarios laborables, pasando de 16,11 pedidos fallidos cada mil en horarios no laborables a 29,77 pedidos fallidos cada mil.

Por su parte, los organismos con sitios de servicios aumentan sus problemas en horarios no laborables, pasando de 39,49 a 56,11 su tasa de no respuesta en tales horarios.

Finalmente, las Universidades nacionales, por su parte, mantienen estable su cantidad de fallas, en torno a los 42 errores por cada mil con independencia a la franja horaria observada.

Esta variedad sugiere la presencia de una heterogeneidad de problemas detrás de los pobres rendimientos de los sitios estatales de orden nacional. Resultados tan dispares parecen señalar así la coexistencia de plataformas y procesos diferentes para cada uno de los espacios institucionales evaluados.

Con relación a la información relativa a los períodos de consumo eléctrico mensuales superior a la media, un análisis de causas tentativo podría atribuir allí las variaciones a dos factores: al mismo tiempo que diciembre, enero, febrero, junio y julio son los meses de más alto consumo eléctrico (CNEA, 2018), varios de ellos son también meses de receso en la administración pública. Esto hace que su análisis quede sujeto a cualquiera de ambos factores como desestabilizadores de la provisión de servicio (los cortes causados por el alto consumo eléctrico y la mayor o menor estabilidad debida al cambio en el menor número de agentes estatales afectados al trabajo).

En el caso de los ministerios nacionales, al igual que como ocurría con la distribución por franja horaria, sus sitios muestran un mayor número de fallas en la franja de mayor laboralidad, es decir, en los meses de bajo consumo eléctrico. De este modo, mientras que fallan en 15,96 pedidos cada mil en meses de alto consumo eléctrico (donde podría haber cortes de luz y personal en vacaciones), el número de fallos se ubica casi en el doble en los demás meses, llegando a 29,09 casos por cada mil pedidos.

Nuevamente, los organismos estatales mostraron un comportamiento opuesto al de los sitios institucionales de los ministerios de los que dependen, pasando las fallas por cada mil pedidos de 38,09 en época de bajo consumo a 59,39 en época de alto consumo.

Las Universidades nacionales, también en consonancia con lo visto respecto a las franjas horarias en sus servidores, no muestran diferencias significativas según época del año, no resultando su alto nivel de fallas atribuible ni a momentos específicos de la semana (laborable / no laborable) ni a tramos particulares del año.

En cuanto a los tiempos de respuesta, tal como se muestran en la Figura 3, apenas registran variaciones dentro o fuera del horario laborable, lo que haría suponer que los servidores en cuestión no se encuentran bajo extrema carga de demanda a lo largo de la semana. Si hubiera una demanda que ralentizara los tiempos de respuesta, posiblemente se concentraría o bien en la franja en que las personas se encuentran en sus hogares, o bien cuando resuelven demandas desde sus espacios laborales, pero difícilmente seria homogénea todo a lo largo del día.

Figura 3

Variaciones en la disponibilidad y tiempo de respuesta en sitios dependientes del Estado nacional según franja horaria. Período: enero-diciembre 2017.

*TTR: tiempo total de respuesta, en segundos.

**Alto: superior al consumo medio mensual de 363 GWh, incluyendo los meses de enero, febrero, junio, julio, diciembre. Bajo: demás meses, con consumo inferior al consumo promedio (CNEA, 2018).

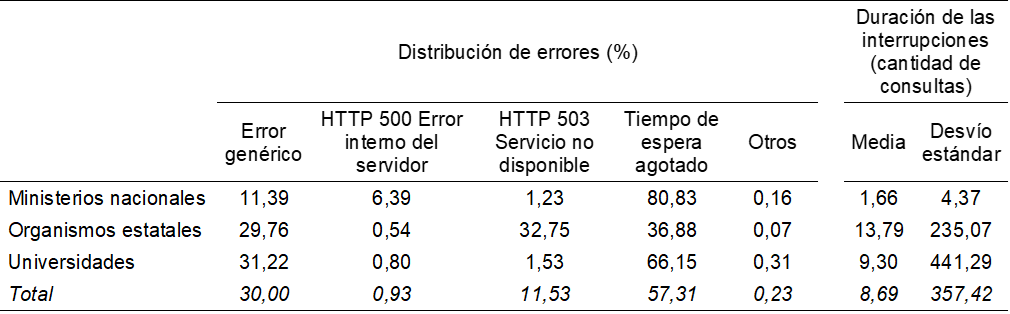

Fuente: elaboración propia en base a relevamiento de disponibilidadEn la Figura 4 puede verse el registro de no respuesta para las diferentes categorías de sitios dependientes del estado nacional, así como la duración media de las interrupciones. Aquí nuevamente el comportamiento es disímil en los tres grupos, confirmando la impresión previa respecto a la heterogeneidad estructural de la infraestructura electrónica del estado nacional.

En el caso de los ministerios nacionales, la falla registrada más frecuente es ‘Tiempo de espera agotado’, reuniendo un 80,83% de los casos. Esta falla es registrada por el monitor cuando una página, luego de establecerse exitosamente la conexión, no logra responder el pedido tras 20 segundos de espera. En términos técnicos, esto puede ocurrir por una diversidad de razones, pero siempre supone que la página solicitada ha quedado a la espera de un recurso que precisaba, tales como conexión de red hacia otro servidor o acceso a un registro en las bases de datos que otro proceso estaba escribiendo. La segunda razón más frecuente en este grupo es ‘Error genérico’, con 11,39% de los casos. Este tipo de error implica que cuando el monitor quiso iniciar una conexión con el servidor remoto, la conexión no se pudo establecer. Esto puede deberse a que el servidor remoto no estuviera encendido, pero también a caídas en la conectividad en la red interna o hacia internet del servidor remoto.

Los organismos estatales muestran otro esquema de fallas por tipo de error, agrupándose los errores más frecuentes en tres grupos de tamaño similar, siendo también el más numeroso el de ‘Tiempo de espera agotado’ pero no superando el 36,88% de los casos. La segunda razón más frecuente de falla que aparece en este grupo es el error de HTTP 503, con 32,75% de los casos, que ocurre cuando el servidor web puede conectarse con el solicitante pero falla al tratar de armar la página de respuesta por no estar ejecutable el sitio solicitado. Estos errores –al igual que el error HTTP 500- suelen ocurrir al ponerse online versiones parciales o defectuosas en procesos de actualización del software, o por fallas en un recurso del que el sitio pueda depender (como un servidor de base de datos). El tercer grupo es ‘Error genérico’, con 29,76% de los casos, que tal como se mencionó anteriormente representa la desconexión del servidor respecto de las solicitudes externas.

En la franja de universidades, ‘Tiempo de espera agotado’ es el tipo de problema más frecuente –al igual que en los ministerios- con un 66,15% de los casos, seguido por un 31,22% de ‘Error genérico’.

Para cada uno de estos grupos se ha calculado la duración de las interrupciones, entendiéndose por duración la cantidad de pedidos sucesivos que un sitio falló en responder ante la ocurrencia de un error. Con esto se buscó distinguir entre la existencia de no respuestas puntuales a pedidos (como las que pueden ocurrir por excesivos pedidos concurrentes o pequeños gaps en la actualización de un servidor) de fallas sostenidas que excedieran el intervalo de 10 minutos establecido como ventana entre las mediciones del monitor.

El análisis de estas duraciones presenta también una imagen diversa, siendo los organismos estatales aquellos que registraron caídas más prolongadas, teniendo un promedio de 13,79 pedidos. Si consideramos que entre cada pedido hay pausas de 10 minutos, esta cantidad de pedidos implica que en promedio por cada interrupción el monitor no pudo conectarse con los servidores por aproximadamente 2 horas y media. Las universidades se encuentran segundas en la duración promedio de las fallas (con un gran desvío estándar, al igual que los anteriores) con un promedio de 9,3 pedidos (equivalente a una hora con cuarenta minutos sin respuesta). Los ministerios nacionales mostraron por su parte intervalos significativamente más cortos, sin llegar a superar en promedio la marca de 1,66 pedidos por grupo de falla.

Figura 4

Distribución de tipo de error y duración de las interrupciones de servicio en sitios dependientes del Estado nacional. Período: enero-diciembre 2017.

Fuente: elaboración propia en base a relevamiento de disponibilidad

Peores 10

En virtud de que un análisis detallado de cada grupo excede los alcances de este artículo, y que su propósito es facilitar una mirada general sobre las capacidades y la heterogeneidad de la infraestructura dependiente del Estado nacional, serán analizados a continuación solamente algunos casos dentro del conjunto de servidores estatales.

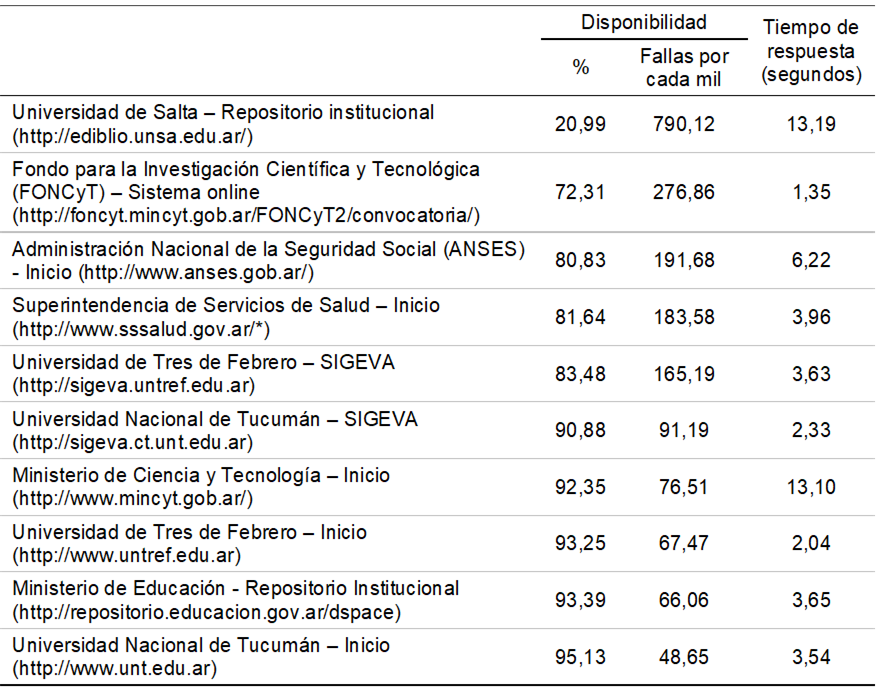

Para ello, se presenta en la Figura 5 los 10 sitios con peor disponibilidad dentro de los 59 sitios dependientes del Estado nacional evaluados. Esta lista incluye los 10 sitios que no han logrado superar el 95% de disponibilidad, estando algunos de ellos muy por debajo de esa marca. Estos casos permiten dar cuenta de la gran variabilidad entre los diferentes servicios y, especialmente, de la importancia de algunos de los sitios más deficientes en términos de disponibilidad del servicio.

Figura 5

Disponibilidad y tiempo de respuesta para los 10 sitios de peor rendimiento. Período: enero-diciembre 2017.

* La ruta ha cambiado en la actualidad, pero era la correcta durante el período de medición.

Fuente: elaboración propia en base a relevamiento de disponibilidadCon relación a la masividad de su uso, sin dudas el sitio de Administración Nacional de la Seguridad Social (ANSES) –dedicado a la difusión de información y al acceso a trámites para cobertura de asignaciones familiares, jubilaciones, pensiones y otros beneficios sociales- es de todos aquel del cual podría esperarse un mayor impacto por su falta de disponibilidad. Mientras que su página de inicio apenas alcanza un 80,83% de respuestas exitosas, su tiempo de respuesta promedio es de 6,22 segundos, muy por encima del 1,06 segundos que mostraban en la Figura 2 los diarios nacionales, o los 2,21 segundos de los sitios de comercio electrónico.

Por su significatividad en el acopio de conocimiento técnico, causa cierta sorpresa que el sitio institucional del Ministerio de Ciencia y Tecnología esté en la lista de los 10 peores sitios, con más de 76 pedidos rechazados por cada mil con una tasa de disponibilidad de 92,35%.

También dependiente del Ministerio de Ciencia y Tecnología, es el segundo peor sitio de la lista el sistema online del Fondo para la Investigación Científica y Tecnológica (FONCYT). Este sistema es el portal por medio del cual los investigadores de las diversas áreas de conocimiento del país solicitan y administran una de las principales vías de financiamiento para sus proyectos de investigación (las líneas de proyectos PICT). Según se desprende de la presente medición, en su página de identificación, este sitio durante 2017 apenas logró responder un 72,31% de las veces a las solicitudes del monitor[13].

Conclusiones

Por medio de un registro sistemático realizado durante el año 2017, se ha podido evaluar la disponibilidad de un conjunto de 59 sitios dependientes del estado nacional en la Argentina.

Para ello se ha preparado y puesto a funcionar un monitor de páginas, el cual elaboró un registro histórico de las fallas ocurridas a lo largo del período en cada sitio. Este esquema de medición puede ser reutilizado para la infraestructura de otros países, o para repetir en el futuro la experiencia en la Argentina.

Como principales emergentes de la medición para el caso de la Argentina cabe destacar al menos cuatro elementos salientes.

En primer lugar, los sitios dependientes del Estado nacional mostraron un rendimiento muy inferior en comparación con los demás sitios incluidos como referencia, ya fueran estos medios de prensa, de comercio electrónico o páginas de la administración de la Ciudad de Buenos Aires.

Como segundo elemento, esto sugiere que buena parte de las fallas registradas no pueden atribuirse sin más a limitaciones de la infraestructura nacional, tal como una frágil provisión de electricidad o de conectividad. Incluso si estos factores estuvieran presentes, resulta claro que otras ramas de actividad logran sobreponerse con mayor éxito a estos factores que el Estado nacional.

En tercer lugar, la infraestructura de información pública de la administración nacional parece –a la luz de los resultados analizados- compuesta por aplicaciones y servidores heterogéneos, siendo sus patrones de falla diferentes a nivel de ministerios, de organismos descentralizados y de la red de Universidades públicas nacionales.

Por último, hemos podido dar cuenta de que las fallas ocurren tanto en sitios secundarios del Estado nacional (donde podría esperarse un menor número de consultas, y finalmente, un menor impacto por sus fallas en la población) como entre los más importantes de ellos. Dentro de la heterogeneidad señalada, no parece haber distinción o garantías diferenciales entre centro y periferia de la administración pública, siendo la Administración Nacional de la Seguridad Social (ANSES) y el Ministerio de Ciencia y Tecnología dos de los más afectados por los bajos rendimientos de sus plataformas, junto a sitios menos consultados como repositorios académicos del interior del país.

Referencias bibliográficas

Barité, M. y López Huertas, M. J. (2004). Los sitios Web de legislación en el Mercosur: un análisis comparativo. Ciência da Informação, 33(2), 28-38.

Choudrie, J., Ghinea, G., y Weerakkody, V. (2004). Evaluating global e-government sites: a view using web diagnostics tools. Academic Conferences International.

CNEA (2018). Síntesis del mercado eléctrico mayorista de la República Argentina. Comisión Nacional de Energía Atómica, Nº 205.

Defensoría del Pueblo (2016). Seguimiento del sistema de inscripciones en línea del Ministerio de Educación del Gobierno de la Ciudad de Buenos Aires-Ciclo lectivo 2015. Informe técnico. Buenos Aires: Defensoría del Pueblo la Ciudad de Buenos Aires.

Halaris, C., Magoutas, B., Papadomichelaki, X. y Mentzas, G. (2007). Classification and synthesis of quality approaches in e-government services. Internet Research, 17(4), 378-401.

Kaufman, E. (2006). Sobre políticas y medios de gestión para el gobierno electrónico y la sociedad de la información y el conocimiento. Las recetas ajenas y los posibles desarrollos propios. Estado, gobierno, gestión pública. Revista chilena de Administración Pública, 8, 125-165.

Levis, D. (2006). Alfabetos y saberes: la alfabetización digital. Comunicar, 26, 78-82.

Naser, A., Ramírez-Alujas, Á. y Rosales, D. (2017). Desde el gobierno abierto al Estado abierto en América Latina y el Caribe. Santiago de Chile: CEPAL.

Olvera Lobo, M. D. y Aguilar-Soto, M. (2011). Los sitios web académicos con información de postgrado: herramientas para su evaluación. Investigación Bibliotecológica, 25(53), 31-57.

Papadomichelaki, X., Magoutas, B., Halaris, C., Apostolou, D. y Mentzas, G. (2006) A Review of Quality Dimensions in e-Government Services. En M.A. Wimmer, H.J. Scholl, Å. Grönlund, K.V. Andersen (Eds), Electronic Government. EGOV 2006. Lecture Notes in Computer Science, vol. 4084. Berlín: Springer.

Russo, A. y De Grande, P. (2015). Los repositorios institucionales de acceso abierto y el rol del autor: una lectura de la ley argentina de repositorios. 4tas Jornadas de Intercambio y Reflexión acerca de la Investigación en Bibliotecología (JIRIB). Facultad de Humanidades y Ciencias de la Educación. Universidad Nacional de La Plata, La Plata.

Venkatraman, S., y Alazab, M. (2014). Quality Approaches for Performance Measurement in Jordanian E-Government Services. En Z. Mahmood (Ed.), IT in the Public Sphere: Applications in Administration, Government, Politics, and Planning (pp. 99-119). Hershey, Estados Unidos: IGI Global.

Notas

Información adicional

JEL: H410